elasticsearch 2.3.4 安装中文分词(windows环境)

By:Roy.LiuLast updated:2016-07-14

为什么采用elasticsearch, 还有一个重要的原因就是分词处理,对于其他文档数据库来说,很难做到这一点,比如尝试找在mongodb 中处理中文分词的工具,到目前为止基本没找到好用的,而elasticsearch是基于apache lucene, 所以分词很好处理, 这里主要记录安装配置测试elasticsearch-analysis-ik的过程

分词源码下载地址:https://github.com/medcl/elasticsearch-analysis-ik

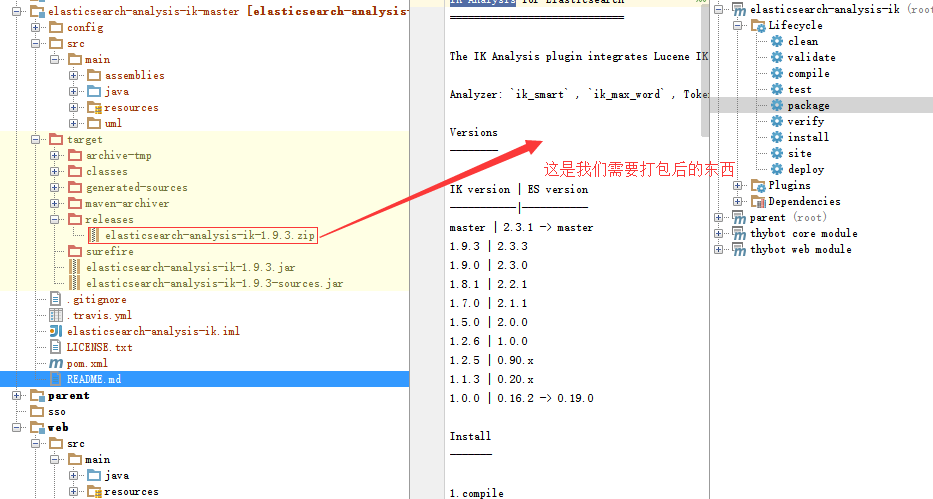

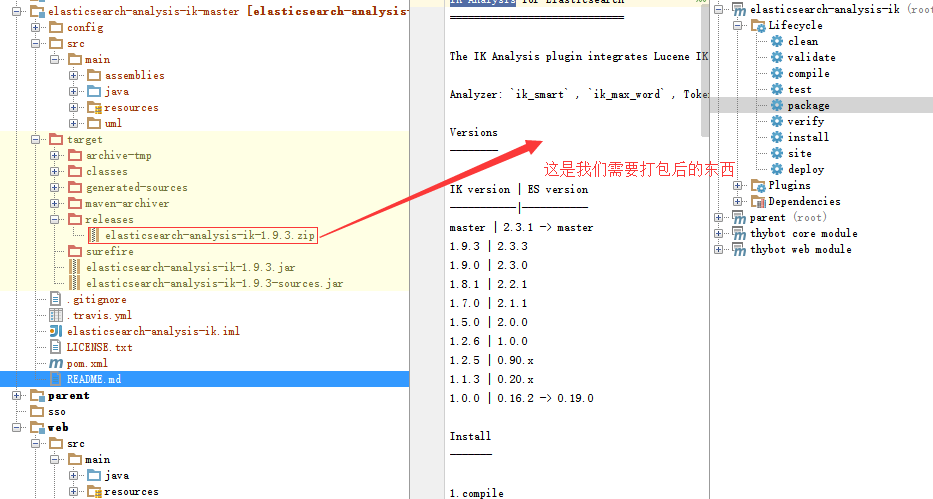

需要自己安装maven,并编译,maven的安装配置就不说了,我这里直接导入到开发工具中,直接用工具编译出来,当然也可以直接用命令行处理,这不是重点,生成之后的结果如下:

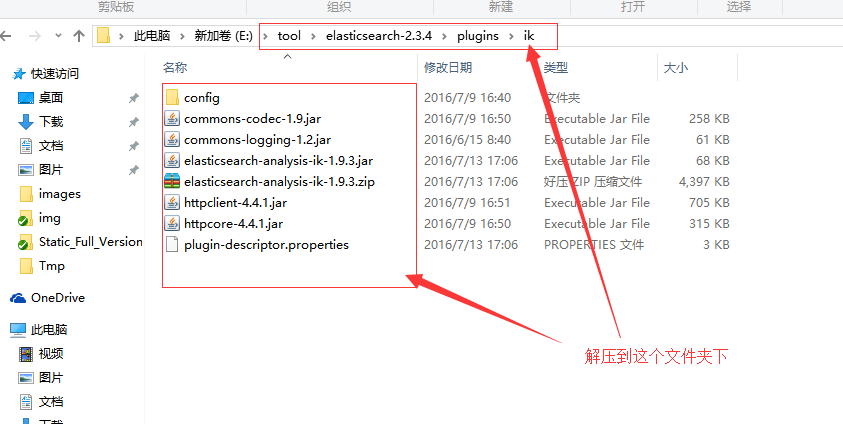

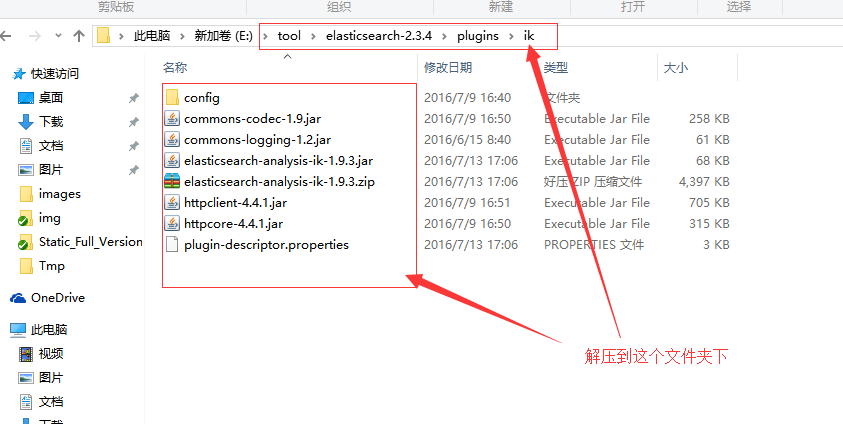

可以看到生成的:elasticsearch-analysis-ik-1.9.3.zip 文件,这就是我们需要的,把它拷贝到elasticsearch 的安装目录下的plugins目录下的ik目录下,并解压,如下图:

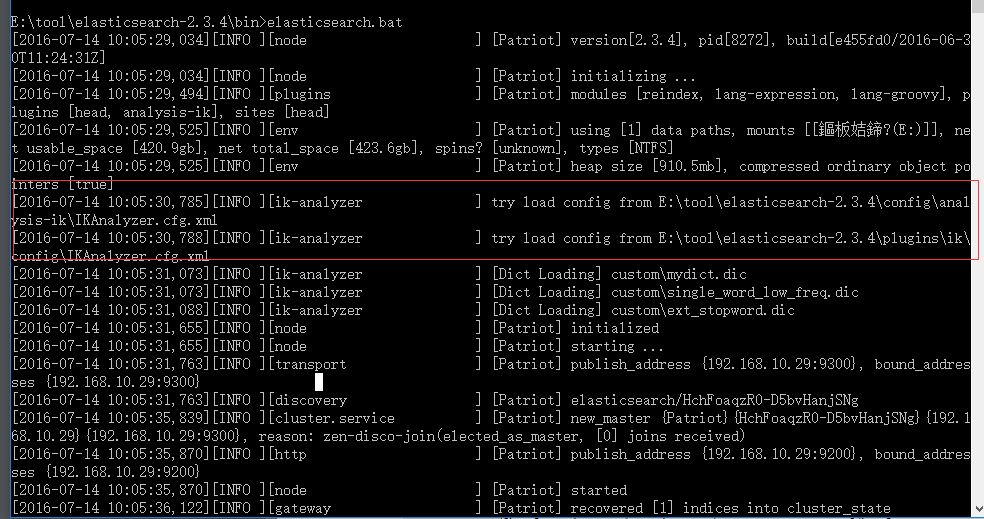

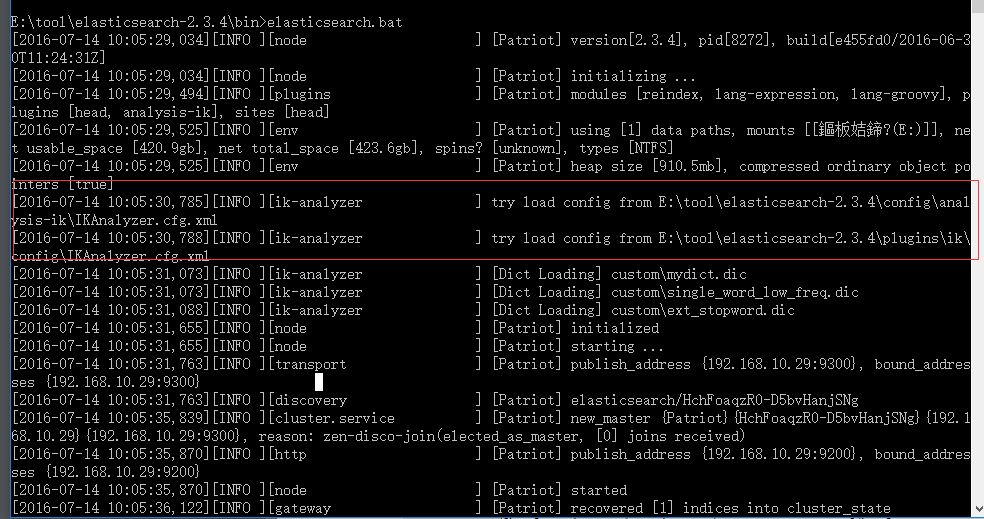

然后我们重启 elasticsearch, 看到如下提示:

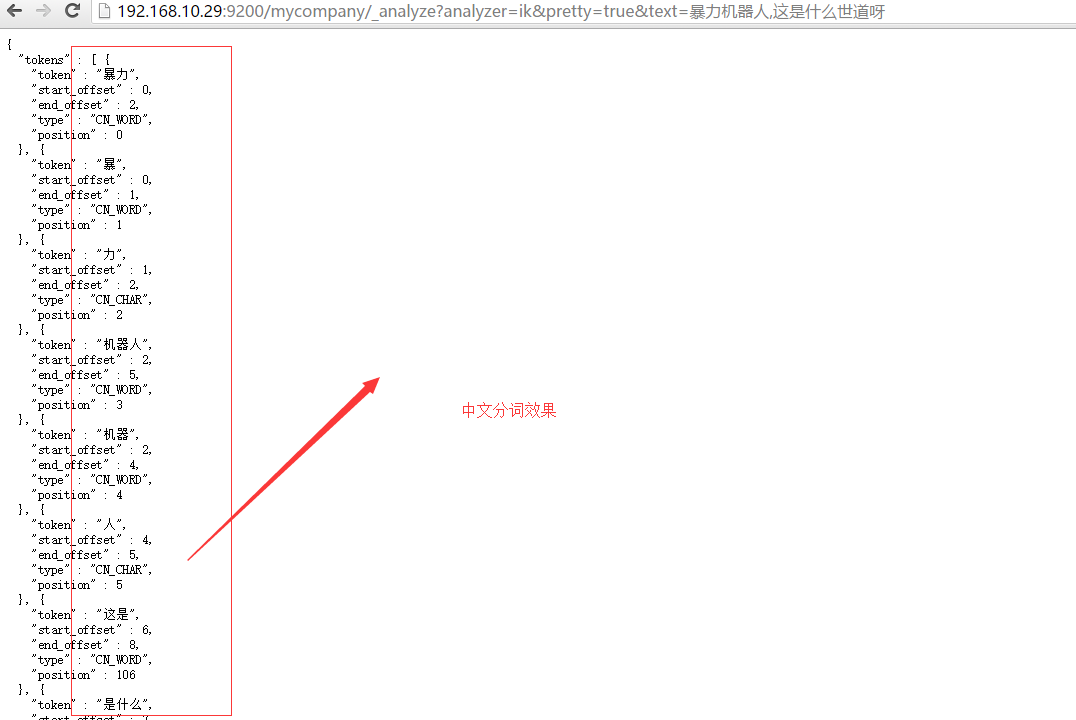

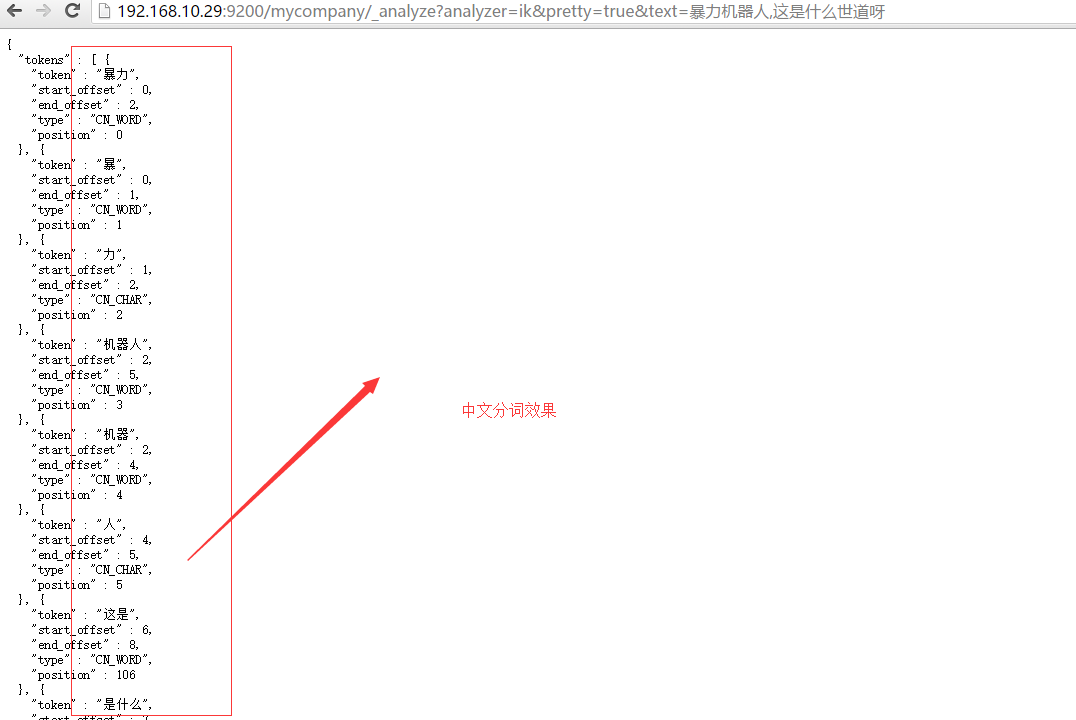

看到加载分词成功, 这个时候,可以做一个测试,就是直接在浏览器中做测试,比如输入如下一个地址:

PS:

如果要安装smartcn分词的话,用如下命令: plugin install analysis-smartcn

分词源码下载地址:https://github.com/medcl/elasticsearch-analysis-ik

需要自己安装maven,并编译,maven的安装配置就不说了,我这里直接导入到开发工具中,直接用工具编译出来,当然也可以直接用命令行处理,这不是重点,生成之后的结果如下:

可以看到生成的:elasticsearch-analysis-ik-1.9.3.zip 文件,这就是我们需要的,把它拷贝到elasticsearch 的安装目录下的plugins目录下的ik目录下,并解压,如下图:

然后我们重启 elasticsearch, 看到如下提示:

看到加载分词成功, 这个时候,可以做一个测试,就是直接在浏览器中做测试,比如输入如下一个地址:

http://192.168.10.29:9200/mycompany/_analyze?analyzer=ik&pretty=true&text=暴力机器人,这是什么世道呀

PS:

如果要安装smartcn分词的话,用如下命令: plugin install analysis-smartcn

From:一号门

Previous:elasticsearch 入门篇

COMMENTS